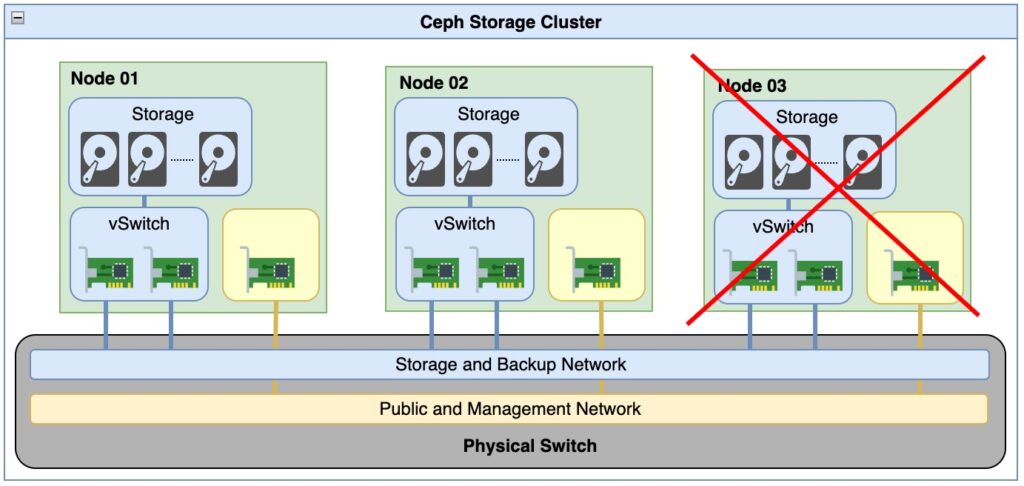

Trường hợp 1 node trong cụm có 3 node bị hỏng.

Khi bạn triển khai một cụm Ceph với 3 node chạy replica 3, tức là mỗi đoạn dữ liệu sẽ được sao chép thành 3 bản sao trên 3 node khác nhau. Nếu bạn tắt một node trong cụm, dữ liệu vẫn sẽ sẵn có trong hai node còn lại, do đó, bạn không mất dữ liệu. Ceph sẽ tiếp tục hoạt động với hai bản sao của dữ liệu mà bạn cần, vì nó có khả năng chịu lỗi và sao chép dữ liệu đồng bộ trên các node.

Tuy nhiên, lưu ý rằng khi một node bị tắt và dữ liệu vẫn phải được sao chép trên các node khác, hiệu suất có thể bị ảnh hưởng và sự truy cập vào dữ liệu có thể trở nên chậm hơn trong thời gian tắt node. Khi bạn khởi động lại node bị tắt, Ceph sẽ bắt đầu đồng bộ hóa dữ liệu trên nó để đảm bảo rằng có ba bản sao của dữ liệu trên ba node.

Như vậy với cụm Ceph có 3 node chạy replica 3, bạn không mất dữ liệu khi tắt một node, nhưng có thể gây ra hiệu suất kém hơn trong thời gian tắt node và đồng bộ lại dữ liệu khi node được khởi động lại.

Thời gian cụm Ceph cần để hoạt động trở lại sau khi một node bị hỏng.

Thời gian cụm Ceph cần để hoạt động trở lại sau khi một node bị tắt và được khởi động lại có thể biến đổi dựa trên nhiều yếu tố, bao gồm:

- Dung lượng: Thời gian cần thiết để đồng bộ hóa dữ liệu sẽ phụ thuộc vào lượng dữ liệu bạn lưu trữ trong cụm Ceph. Dung lượng lớn hơn sẽ đòi hỏi thời gian lâu hơn.

- Hiệu suất của hệ thống: Tốc độ xử lý và băng thông của các node Ceph cũng sẽ ảnh hưởng đến thời gian đồng bộ hóa dữ liệu. Hệ thống nhanh hơn sẽ hoàn thành quá trình này nhanh hơn.

- Phụ thuộc vào tải của hệ thống hiện tại: Nếu cụm Ceph đang gặp tải làm việc cao, thì quá trình đồng bộ hóa và khôi phục có thể mất thời gian hơn.

- Cấu hình của Ceph: Cách bạn cấu hình Ceph và OSD cũng có thể ảnh hưởng đến thời gian khôi phục. Các cấu hình replica, số lượng PG (Placement Groups), và các cài đặt khác có thể thay đổi thời gian này. Hoặc loại OSD (Object Storage Daemon) bạn sử dụng, cũng có thể ảnh hưởng đến thời gian khôi phục.

Trong nhiều trường hợp, Ceph có khả năng đảm bảo rằng dữ liệu vẫn có sẵn khi một node bị tắt, nhưng thời gian để hoàn tất việc đồng bộ hóa và khôi phục có thể từ vài phút đến vài giờ, tùy thuộc vào các yếu tố đã nêu trên. Để biết thông tin cụ thể về thời gian khôi phục trong tình huống cụm Ceph cụ thể của bạn, bạn cần thử nghiệm và theo dõi hiệu suất của cụm trong các tình huống thực tế.

Gợi ý phương án ứng cứu node bị hỏng.

Nếu một node của bạn đã hỏng hoàn toàn và bạn chỉ còn lại 2 node, bạn có thể thực hiện các bước sau để đảm bảo rằng cụm Ceph vẫn hoạt động được:

- Khởi động lại node còn lại: Đảm bảo rằng node còn lại đang hoạt động và hoạt động đúng cách.

- Cân nhắc cấu hình: Với chỉ còn 2 node, bạn không thể duy trì mô hình replica 3 mà bạn đã triển khai trước đây vì cần ít nhất 3 node để đảm bảo 3 bản sao của dữ liệu. Bạn có thể chuyển sang mô hình replica 2 hoặc 1 tùy thuộc vào mức độ độ tin cậy và khả năng phục hồi bạn cần.

- Điều chỉnh pool: Nếu bạn muốn thay đổi replica count hoặc cấu hình pool khác, bạn cần sử dụng lệnh

ceph osd pool set <pool-name> size <new-size>để điều chỉnh số bản sao của dữ liệu. - Kiểm tra lại quá trình khôi phục: Sau khi điều chỉnh cấu hình, bạn cần theo dõi quá trình khôi phục để đảm bảo rằng dữ liệu được sao chép đúng cách theo cấu hình mới.

- Xem xét cân bằng OSDs: Nếu bạn có nhiều OSDs trên các node, hãy xem xét cách bạn phân phối dữ liệu trên các OSDs để đảm bảo tính cân bằng và hiệu suất tốt hơn.

- Thực hiện kiểm tra thường xuyên: Thực hiện kiểm tra định kỳ trên cụm Ceph để đảm bảo rằng nó vẫn hoạt động đúng cách và không gặp vấn đề.

Lưu ý rằng một cụm Ceph với chỉ 2 node sẽ không có tính khả năng chịu lỗi cao như một cụm với nhiều node hơn, vì nếu một node khác gặp sự cố, cụm có thể bị gián đoạn. Điều này cần được xem xét trong việc lựa chọn cấu hình và quản lý cụm Ceph của bạn.

Ceph không tự động thay đổi cấu replica count khi có sự cố xảy ra.

Việc điều chỉnh số bản sao của dữ liệu (replica count) trong một pool của Ceph không được thực hiện tự động khi một node hỏng. Ceph không tự động thay đổi cấu hình pool khi có sự cố xảy ra. Thay đổi replica count yêu cầu sự can thiệp của người quản trị cụm Ceph.

Khi bạn gặp tình huống một node hỏng và bạn chỉ còn lại 2 node, bạn nên xem xét điều chỉnh replica count của pool để phù hợp với cấu hình mới. Bạn có thể sử dụng lệnh ceph osd pool set <pool-name> size <new-size> để thay đổi replica count cho pool cụ thể. Thay đổi này có thể là replica 2 hoặc replica 1 tùy theo mức độ độ tin cậy mà bạn cần.

Lưu ý rằng sau khi thay đổi replica count, Ceph sẽ bắt đầu quá trình tái sao chép dữ liệu để đảm bảo rằng nó tuân thủ cấu hình mới. Thời gian để hoàn thành quá trình này phụ thuộc vào kích thước dữ liệu và hiệu suất của hệ thống.

Khi bạn điều chỉnh replica count từ 3 xuống 2 sau khi một node hỏng và bạn chỉ còn lại 2 node, thì một số bản sao của dữ liệu sẽ bị loại bỏ. Điều này có nghĩa rằng dữ liệu trên cụm Ceph của bạn không còn đủ ba bản sao như ban đầu. Trong trường hợp này, dữ liệu không bị hỏng hoặc mất, nhưng tính khả năng chịu lỗi của cụm Ceph sẽ bị giảm đi.

Khi bạn thực hiện điều chỉnh replica count, Ceph sẽ tiến hành loại bỏ các bản sao dư thừa sao cho số bản sao còn lại theo cấu hình mới. Dữ liệu vẫn tồn tại trên cụm, nhưng nếu một trong hai node còn lại gặp sự cố, có thể dẫn đến mất dữ liệu. Do đó, bạn cần xem xét rất cẩn trước khi giảm replica count và đảm bảo rằng bạn chấp nhận rủi ro về tính khả năng chịu lỗi thấp hơn.

Trường hợp bị hỏng 2 node và chỉ còn một node.

Khi bạn có replica 2 và chỉ còn lại 2 node trong cụm Ceph, dữ liệu của bạn không có đủ bản sao để đảm bảo tính khả năng chịu lỗi nếu một node nữa gặp sự cố. Trong tình huống chỉ còn một node hoạt động và một node khác gặp sự cố, dữ liệu của bạn có thể bị mất.

Điều này là do khi bạn có replica 2, dữ liệu được sao chép thành hai bản sao trên hai node khác nhau. Nếu một node hỏng và bạn chỉ còn lại một node, không còn bản sao dự phòng để đảm bảo tính khả năng chịu lỗi. Điều này tạo ra một tình huống rủi ro và có thể dẫn đến mất dữ liệu nếu node còn lại gặp sự cố.

Nếu tính khả năng chịu lỗi là ưu tiên quan trọng đối với bạn, bạn nên xem xét triển khai cụm Ceph với ít nhất replica 3 hoặc nhiều hơn để đảm bảo rằng dữ liệu của bạn được sao chép đến ít nhất ba node khác nhau, giúp đảm bảo tính khả năng chịu lỗi trong trường hợp sự cố xảy ra.

Cài đặt số lượng bản sao tốt nhất bạn nên làm.

Khi bạn có đủ 3 node trong cụm Ceph, để đảm bảo tính khả năng chịu lỗi tốt nhất, nên cân nhắc đặt replica count (số lượng bản sao) cho pool của bạn là 3.

Với replica 3, mỗi mảng dữ liệu sẽ có 3 bản sao trên 3 node khác nhau. Điều này đảm bảo tính khả năng chịu lỗi cao nhất trong trường hợp một node bị hỏng. Dữ liệu của bạn vẫn sẽ sẵn có và an toàn khi một node gặp sự cố, và cụm Ceph vẫn hoạt động mà không có mất mát dữ liệu.

Tuy nhiên, lưu ý rằng việc tăng replica count có thể tạo ra một số yêu cầu về lưu trữ và băng thông cao hơn. Vì vậy, bạn nên xem xét mức độ quan trọng của tính khả năng chịu lỗi so với sự sẵn có của tài nguyên và hiệu suất của hệ thống Ceph.

Khi hỏng 1 node Ceph sẽ không tự động chuyển về thông số replica count của min_size.

Trong trường hợp một trong 3 node hỏng và bạn đã cấu hình replica count là 3 và min_size là 2, Ceph sẽ không tự động thay đổi replica count hoặc min_size. Ceph không thay đổi cấu hình pool tự động khi có sự cố xảy ra.

Việc thay đổi replica count hoặc min_size là một quá trình quản trị và phải được thực hiện thủ công bởi người quản trị. Điều này có nghĩa rằng sau khi một trong 3 node hỏng, bạn cần thực hiện cài đặt lại replica count hoặc min_size nếu bạn muốn thay đổi cấu hình của pool.